作为一个网站制作加优化的公司,是需要要回的就是robots.txt文件,所以大家就来看看这个文件的意思

robots.txt是一个纯文本文件,用于声明该网站中不想被蜘蛛访问的部分,或者指定蜘蛛抓取的部分。不是规定,而是一种约定,需要蜘蛛自觉遵守的一种风俗

当蜘蛛访问一个站点时,它会第一检查该站点是不是存在robots.txt

假如找到,蜘蛛就会根据该文件中的内容来确定抓取的范围

假如该文件没有,那样蜘蛛就沿着链接直接抓取

robots.txt有哪些用途

1、预防私密或要紧内容被搜索引擎抓取

2、节省服务器资源,从而提升服务水平

3、降低重复抓取,提升网站水平

4、指定sitemap文件地方

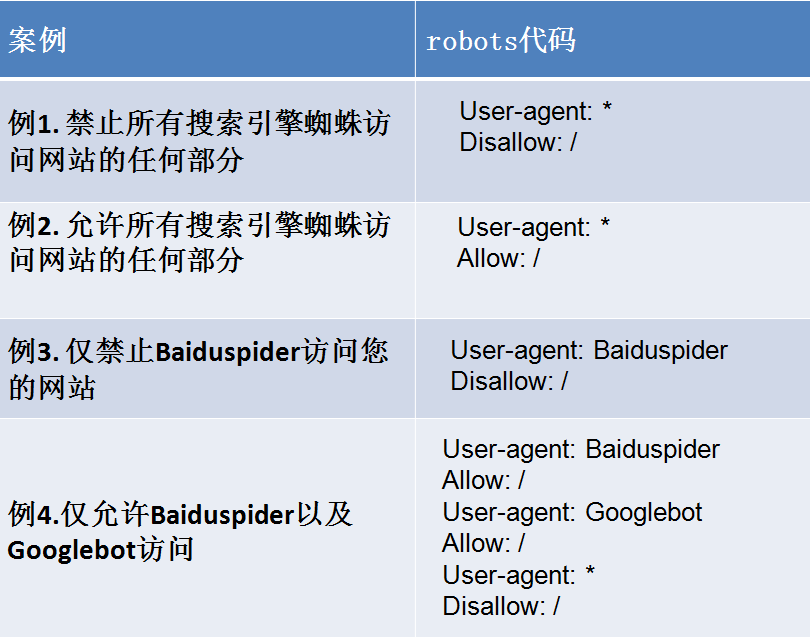

User-agent: *

针对什么搜索引擎蜘蛛

这里的*代表搜索引擎类型,*是通配符

Allow

概念的是允许蜘蛛抓取某个栏目或文件

Allow: /cgi-bin/

这里概念是允许访问cgi-bin目录

Allow:/* .htm$

允许访问以".htm"为后缀的URL

$指的是匹配行结束符

*指的是匹配任何字符

Disallow

概念的是禁止蜘蛛抓取某个栏目或文件

Disallow: /admin/

这里概念是禁止抓取admin目录

Disallow: /cgi-bin/*.htm

禁止抓取/cgi-bin/目录下的所有以".htm"为后缀的URL

Disallow: /*?*

禁止抓取网站中所有包括问号 “?”的网址

使用方法:sitemap:http://www.谷歌.com/sitemap.xml

sitemap:URL全名(包括http://部分)

告诉搜索引擎蜘蛛这个页面是网站地图

robots.txt文件主如果限制整个站点或者目录的蜘蛛访问状况,而robots meta标签则主如果针对某个具体的页面